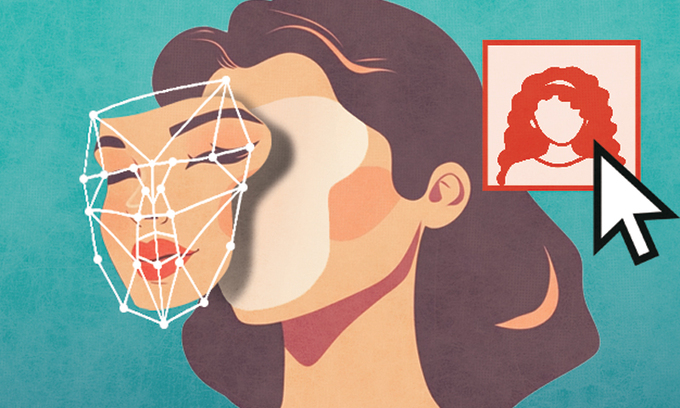

특정인 목소리 합성해 가짜 음성 만드는 ‘딥보이스’도

인공지능 기술 범죄 악용… 유사 범죄 발생 가능성 커

외국인 A씨가 낯선 이로부터 영상을 건네받은 것은 지난달이다. 한국에 여행을 간 딸이 감금된 채 울면서 살려달라고 하는 내용이었다.

낯선 이는 “당신 딸을 납치했다”며 “딸을 살리고 싶으면 합의금을 보내라”고 협박했다. A씨는 이 사실을 영사관에 알렸다. 영사관의 신고를 받고 출동한 한국 경찰은 A씨 딸이 무사한 사실을 파악했다. A씨가 받은 딸의 영상은 ‘딥페이크’(인공지능 등을 활용한 영상 편집물)인 것으로 확인됐다.

경찰청 국가수사본부는 7일 “딥페이크 기술로 자녀의 얼굴을 합성한 가짜 영상을 제작해 금전을 요구한 외국인 대상 전화금융사기(보이스피싱)가 발생했다”며 “국내에서도 유사한 사건이 발생할 가능성이 있으므로 각별히 주의해달라”고 밝혔다.

경찰이 공개한 이 사건에서 실제 피해는 발생하지 않았다. 다만 인공지능(AI) 기술이 범죄에 악용될 수 있다는 점을 보여줬다는 점에서 심각성이 있다는 게 경찰 측 설명이다. 올해 9월까지 납치를 빙자한 보이스피싱 사건은 174건이 일어난 만큼, 딥페이크를 활용한 유사 사례가 앞으로도 충분히 발생할 가능성을 배제할 수 없다.

특정 인물의 목소리를 합성해 가짜 음성을 만드는 ‘딥보이스’ 역시 주의 대상이다. 자녀의 목소리를 복제해 “살려 달라”, “돈을 빌려 달라”는 목소리를 들려줄 수 있어서다.

경찰은 딥페이크와 딥보이스의 진위는 전문가들조차 맨눈으로 판단하기 어려운 만큼, 평소 사회관계망서비스(SNS)에 불특정 다수가 볼 수 있는 공개 설정으로 게시물을 올리는 것을 지양할 필요가 있다고 당부했다. 실제 인물을 대상으로 학습해야 하므로 SNS에 올라온 영상과 사진, 목소리 등이 범죄조직의 표적이 될 수 있다는 것이다.

이 같은 전화를 받았을 땐 실제 납치 여부와 무관하게 경찰에 신고하는 것이 중요하다. 경찰청 관계자는 “범인이 전화를 끊지 못하도록 협박해 경찰에 신고하기 곤란한 경우에는 주변 사람에게 도움을 청하거나, 통화하면서 문자메시지로 112에 신고해 자녀의 안전을 확인하는 방식으로 대처해야 한다”고 조언했다.

[ⓒ 세계일보 & Segye.com, 무단전재 및 재배포 금지]

![[설왕설래] 내기 사이트만도 못한 주류 언론](http://img.segye.com/content/image/2024/11/08/128/20241108500080.jpg

)

![[기자가만난세상] 장관 없는 세종](http://img.segye.com/content/image/2024/11/07/128/20241107520812.jpg

)

![[세계와우리] 트럼프, 강대국 정치의 귀환](http://img.segye.com/content/image/2024/11/08/128/20241108500071.jpg

)

![[성백유의스포츠속이야기] 스포츠언론의 쇠퇴](http://img.segye.com/content/image/2024/11/07/128/20241107520951.jpg

)