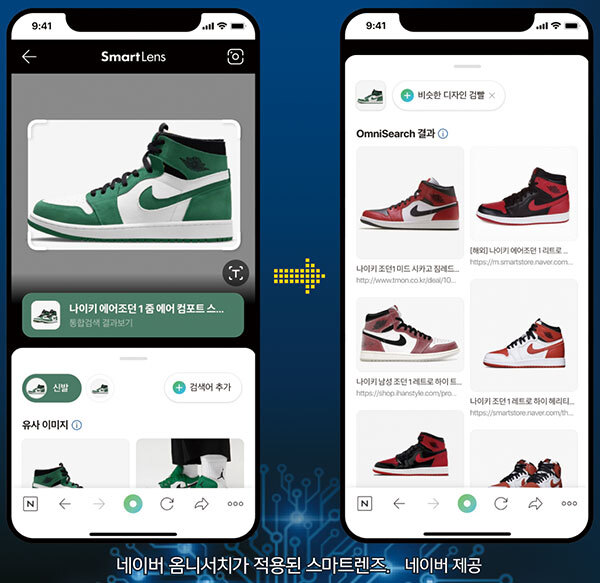

가구·신발 올리면 유사 상품 목록 쫙

장소 찾아주고 음식 영양성분 안내

텍스트 넘어서 이미지 분석해 대화

네이버·카카오 검색엔진·챗봇에 활용

GPT-4V, 인간 얼굴 표정까지 읽어내

구글, 동영상·코드·수학 인식해 처리

갤럭시S24 ‘서치 투 서클’에 탑재돼

#2. AI 스타트업 업스테이지가 만든 카카오톡 채널 ‘AskUp’은 음식 사진을 올리면 영양정보를 제공한다. 떡볶이 사진을 보여주자 ‘떡볶음(떡, 달걀, 고추장 등) 325㎉, 탄수화물 47g, 단백질 11g, 지방 10g’이라고 알려줬다.

챗GPT의 등장 이후 사람들은 AI와 대화할 수 있게 됐다. 텍스트를 입력하면 그에 맞는 문장을 생성한다. AI는 여기에서 한발 더 나아가 이미지나 음성을 이해하고 답하는 멀티모달 AI로 진화하고 있다. 국내외 정보통신기술(ICT) 기업들이 새로운 서비스를 고민하면서 멀티모달 AI 활용은 더 다양해질 전망이다.

4일 업계에 따르면 멀티모달이란 텍스트뿐 아니라 이미지, 음성, 영상, 제스처 등 여러 정보를 이해하고 처리할 수 있는 AI를 말한다. 사람은 시각과 청각, 촉각, 미각 등 여러 정보를 종합해 결론을 도출하는데, AI도 비슷해지는 셈이다. 멀티모달대규모언어모델(MLLM)이나 대규모멀티모달모델(LMM)이라는 용어로 쓰인다.

멀티모달은 AI 가상 비서, 의료, 쇼핑, 교육 및 학습 보조 도구, 자율주행 등 다양한 영역에서 활용될 수 있다. 업계 관계자는 “기존에도 멀티모달 AI가 있었지만, 최근에는 챗GPT와 같은 거대언어모델(LLM)과 결합하면서 더 많은 일을 할 수 있게 됐다”고 설명했다.

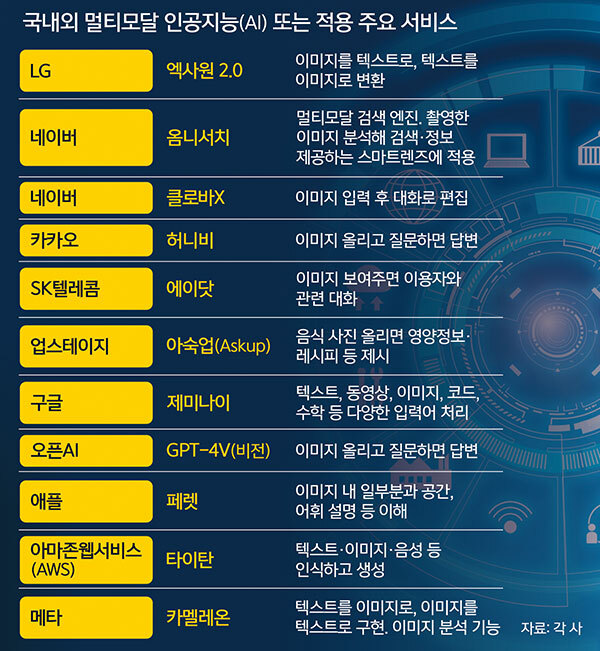

국내에서는 네이버와 카카오, LG 등이 멀티모달 AI를 선보이고 있다.

네이버는 멀티모달 검색 엔진 ‘옴니서치’를 보유하고 있다. 옴니서치는 텍스트와 이미지 등 각기 다른 입력을 조합해 이해한 뒤 검색 결과를 도출한다. 현재 네이버 스마트렌즈에 적용돼 있다. 스마트렌즈로 궁금한 사물을 촬영한 뒤 ‘검색어 추가’를 통해 텍스트를 입력하면 사용자가 원하는 보다 정확한 정보를 얻을 수 있다. 특히 쇼핑 검색 영역에서는 가구, 인테리어 카테고리 내에 1억4000여개 상품을 검색할 수 있다.

네이버의 AI 챗봇 ‘클로바X’에도 지난해 12월 멀티모달이 일부 추가됐다. ‘이미지 편집’ 기능으로, 이미지를 올리고 요청사항을 텍스트로 입력하면 변경된다. 예를 들어 풀밭에 있는 강아지 이미지를 올린 뒤 대화창에 ‘강아지를 토끼로 바꿔줘’라고 하면 이미지가 달라진다. 현재 일부 사용자들을 대상으로 제한적으로 제공하고 있지만, 기능 고도화와 함께 사용자를 계속 확대할 예정이다. 네이버는 음성 등 다른 기능도 추가할 계획이다.

카카오는 최근 MLLM ‘허니비’를 오픈소스로 공개했다. 허니비는 이미지와 텍스트가 혼합된 콘텐츠에 관한 질문을 이해하고 답변할 수 있다. 눈 위에 개와 고양이가 있는 이미지에 대해 “두 동물의 대화를 써줘”라고 입력하면 허니비는 “이미지에서 한 고양이가 눈 속에 누워 있는 개의 등에 앉아 있습니다. 고양이: 냐옹~ 덩치 큰 친구야. 태워줘서 고마워 / 강아지: 왈왈~ 천만에, 내 친구. 네가 내 등에 있어서 너무 좋아”라는 답을 생성해낸다.

LG의 초거대 AI ‘엑사원 2.0’도 멀티모달 모델이다. 특허와 논문 등 약 4500만건의 전문 문헌과 3억5000만장의 이미지를 학습해 언어와 이미지 양방향 생성이 가능하다.

SK텔레콤의 초거대 AI 서비스 에이닷(A.)에도 사진을 보여주며 대화를 이어갈 수 있는 멀티모달 기술이 적용됐다.

해외에서는 오픈AI가 멀티모달 모델에서도 앞서는 모습이다. 지난해 3월 멀티모달 AI 초기 버전인 GPT-4를 공개한 데 이어, 같은 해 9월 업그레이드된 GPT-4V(비전)를 발표했다. GPT-4가 요리 이미지를 업로드하면 조리법을 생성하고, 식재료를 분석하는 수준이었다면 GPT-4V는 이해도가 더 높다. 오픈AI의 보고서를 보면 GPT-4V에 김밥 만드는 사진을 무질서하게 제시한 뒤 순서대로 정렬하라고 명령하면 정확하게 답을 내놓는다. 다양한 얼굴 사진에 나타난 화남, 놀람, 실망 등 감정도 읽어낸다.

구글 제미나이는 텍스트, 동영상, 이미지, 코드, 수학 등 다양한 미디어의 입력을 한 번에 처리할 수 있다. 현재 구글 AI 챗봇 ‘바드’에서 제미나이 기능을 맛볼 수 있다. 기자가 바드에 해변에 앉아 있는 골든 리트리버 사진을 첨부한 뒤 “이미지를 바탕으로 짧은 동화를 써줘”라고 입력하자 바다에서 살길 바라던 리트리버가 결국 그렇게 됐다는 내용으로 ‘꿈은 이루어질 수 있으니 꿈을 잃지 말라’는 교훈을 담은 이야기를 척척 만들어냈다.

이밖에 애플은 멀티모달 LLM ‘페렛’을 오픈소스 형태로 공개했고, 아마존웹서비스(AWS)는 자체개발 LLM ‘타이탄’의 멀티모달 버전을, 메타는 멀티모달 이미지 생성AI 카멜레온을 선보였다.

[ⓒ 세계일보 & Segye.com, 무단전재 및 재배포 금지]

![[설왕설래] 남베트남 패망 50주년](http://img.segye.com/content/image/2025/04/29/128/20250429500191.jpg

)

![[주춘렬 칼럼] 트럼프 협상의 위기](http://img.segye.com/content/image/2025/04/29/128/20250429500162.jpg

)

![[기자가만난세상] 현실 동떨어진 ‘외국인 가사사용인’](http://img.segye.com/content/image/2025/04/29/128/20250429500045.jpg

)

![[최종덕의우리건축톺아보기] 대통령의 집](http://img.segye.com/content/image/2025/04/29/128/20250429500057.jpg

)